Google Fotos ha mejorado su tecnología de reconocimiento facial aumentando la capacidad de identificar personas en las imágenes, ya que ahora también reconoce a los usuarios que aparecen de espaldas y, por tanto, no muestran la cara.

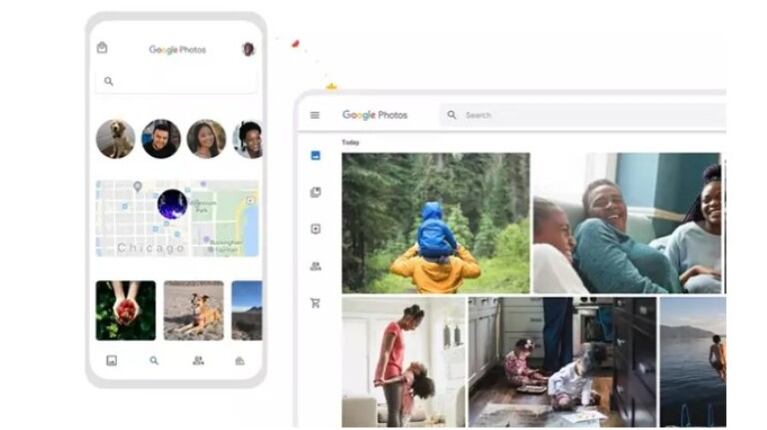

La aplicación de almacenamiento de fotos del gigante tecnológico dispone de una tecnología de reconocimiento facial que analiza las caras que aparecen en las fotografías y etiqueta a las personas a las que pertenecen dichos rostros.

Esta característica es útil para, por ejemplo, crear de forma automática una carpeta con todas las imágenes en las que aparece un usuario en concreto. Hasta ahora, la 'app' ha llevado a cabo esta función a través del análisis de los rostros de los usuarios.

Sin embargo, la compañía parece haber mejorado la tecnología de reconocimiento facial impulsada por Inteligencia Artificial (IA) hasta el punto de ser capaz de reconocer personas que están de espaldas, tal y como han podido comprobar desde Android Authority.

Cuando una fotografía incluye a un usuario de espaldas o en una posición en la que no se puede ver bien su rostro, la aplicación no incluye a personas etiquetadas ni permite añadir etiquetas de forma manual, ya que no identifica a ningún ser humano y, por tanto, no lo considera necesario. No obstante, según detallan en este medio, la tecnología de Google Fotos ha sido capaz de detectar personas en posiciones en las que no muestran su rostro y etiquetar a dichos usuarios correctamente en la imagen.

Además, esto ha ocurrido tanto en imágenes realizadas recientemente como en fotografías antiguas. En estos casos, las etiquetas que facilita Google se muestran con el mensaje "rostro disponible para agregar" y, además, permite cambiar la persona etiquetada o eliminar la etiqueta, en caso de que su identificación no haya sido correcta.

A pesar de que Google no ha compartido información al respecto, este avance en el reconocimiento puede deberse a que la tecnología de la compañía sea capaz de almacenar información de la cabeza al completo de los usuarios a partir de vídeos en los que aparezca o fotos en las que sí se muestre la cara, aunque solo se distinga parte del rostro, tal y como ha apuntado Android Authority.

También pueden influir factores como la similitud de la ubicación con respecto a otras fotografías en las que sí aparezca la cara de la persona o, incluso, otros factores como el entorno y la ropa utilizada. Todo ello enmarcado en las capacidades de aprendizaje automático de Google en las que muestra avances continuos.

Fuente: EP.